| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- impl

- 풀업저항

- Backpropagation

- #9

- cs231n

- Features

- leetcode

- softmax backpropagation

- pullup

- Floating

- error

- autoencoder

- palindrome

- Big size image

- 회로

- KNN

- neural net

- Softmax

- backward pass

- assignment

- assignment1

- pulldown

- TensorFlow

- pyTorch

- two-layer neural net

- NotFoundError

- Circuit

- 풀다운저항

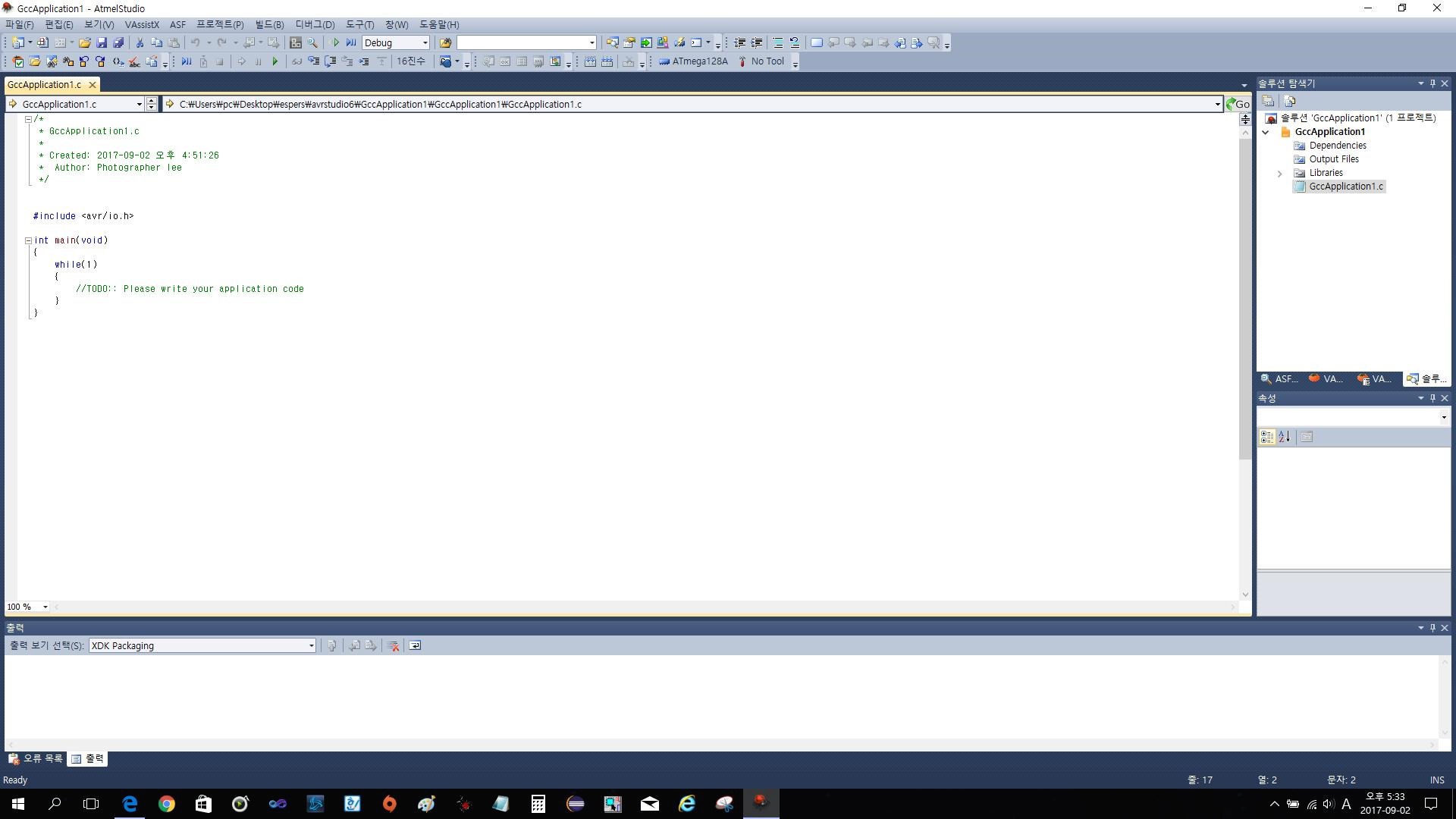

- atmega128

- Solution

- Today

- Total

목록ML , DL (2019)/cs231n (7)

코딩공부

https://github.com/Lee-daeho/cs231n Lee-daeho/cs231n Contribute to Lee-daeho/cs231n development by creating an account on GitHub. github.com 이번 과제는 기존의 과제들을 잘 했다면 문제없이 할 수 있는 수준의 과제였으므로 따로 설명은 하지 않는다. 이번 과제의 특징은 기존의 과제들은 이미지를 pixel단위로 구분하여 training했지만 이번에는 pixel이 아닌 extract한 feature단위로 구분하여 training하였다는 것이 특징이다. feature를 extract하는 데에는 hog(histogram of gradient)와 hsv color를 이용하였다.

cs231n assignment1 - two-layer neural net

cs231n assignment1 - two-layer neural net

과제의 전체 코드는 https://github.com/Lee-daeho/cs231n/tree/master/assignment1에 업로드 되어 있다. 우선 softmax의 backpropagation을 설명해보고자 한다. 코드로는 다음과 같이 표현할 수 있다. 여기서 gradient를 계산하기 위해 backward pass(backpropagation)을 진행해야 하는데 이것을 자세히 풀어보았다. 이런 과정을 통해 각 input의 gradient를 구할 수 있다. 대부분의 코드는 기존의 과제 softmax나 linear classifier를 참조하면서 진행할 수 있으므로 마지막으로 Inline Question만 보겠다. 질문은 training accuracy와 testing accuracy의 차이가 크면 ..

backpropagation, intuition - 2 (요약)

backpropagation, intuition - 2 (요약)

Intuitive understanding of backpropagation backpropagation의 직관적인 이해에대해 설명하는 부분이다. Chain rule은 gate가 gate의 모든 input들에 대해 구해진 gradient를 곱해야 한다고 이야기하고있고, 이러한 모든 input에 대한 곱셈이 상대적으로 쓸모없는 gate를 전체 neural network같은 복잡한 circuit의 톱니바퀴로 바꿔준다고 이 글에서 이야기하고 있다. Backpropagation은 gate들이 최종 결과값을 크게 만들기 위해 자신의 output을 얼마나 증가시키거나 줄이고싶은지에 대해 각각의 gates가 서로 대화하는것과 같다고 생각될 수 있다. -> Backpropagation의 직관적인 이해 Backpropa..

Backpropagation, Intuitions

Backpropagation, Intuitions

지난글에 언급했듯이 Backpropagation, Intuitions 부분을 번역해보았다. Slide가 아닌 http://cs231n.github.io/optimization-2/ 에 있는 내용으로 Slide기준 Lecture 4에 포함된 내용이다. Slide의 일부도 필요에따라 끌어와 사용하였다. Introduction Motivation. In this section we will develop expertise with an intuitive understanding of backpropagation, which is a way of computing gradients of expressions through recursive application of chain rule.(of가 참 많다) Und..

assignment1 - softmax

assignment1 - softmax

softmax classifier는 svm과 내용이 상당히 비슷해서 SVM과 다른부분들만 설명을 하도록 하겠습니다. 설명이 없는 부분은 SVM과 같다고 생각하면 됩니다. 이번에도 코드는 github.com/Lee-daeho/cs231n 에 있습니다. 필요하신 분들은 가서 확인하시면 됩니다. scores를 구하는 부분은 SVM과 같다. 하지만 위의 TODO부분을 보면 If you are not careful here, it is easy to run into numeric instability. 라는 부분이 있다. 주의하지 않으면 numeric instability에 빠질 수 있다. 라는 의미인데 cs231n의 lecture note를 보면 다음과 같은 설명을 찾을 수 있다. Softmax function..

cs231n assignment1 - SVM

cs231n assignment1 - SVM

강의 내용 중 SVM에 관한 설명 부분을 번역해 보았습니다. There are several ways to define the details of the loss function. As a first example we will first develop a commonly used loss called the Multiclass Support Vector Machine (SVM) loss. The SVM loss is set up so that the SVM “wants” the correct class for each image to a have a score higher than the incorrect classes by some fixed margin Δ. Notice that it’s somet..

cs231n assignment1 - knn

cs231n assignment1 - knn

글을 작성하기에 앞서 Ubuntu 환경에서 진행하였으며 anaconda와 같은 가상환경은 사용하지 않았다. cs231n의 강의를듣고 assignment1의 knn과제를 진행하였다. numpy에서 익숙치않은 함수들도 나와서 모두 이해하느라 어제부터 오늘까지 약 8시간은 걸린 것 같다. knn.ipynb파일과 k-nearest-neighbor.py파일은 https://github.com/Lee-daeho/cs231n/tree/master/assignment1 에 가면 확인할 수 있다. 블로그에서는 전체 내용이 아닌 일부분들을 번역하며 설명할 예정이니 전체 파일은 github에서 확인하기 바란다. cs231n의 assignment는 전체 코드의 일부분을 학생이 직접 코딩하여 전체 프로그램을 완성시키는 방식이다..