반응형

Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

Tags

- autoencoder

- Softmax

- TensorFlow

- Circuit

- assignment

- pullup

- impl

- error

- backward pass

- palindrome

- Big size image

- pyTorch

- 풀다운저항

- cs231n

- 회로

- two-layer neural net

- softmax backpropagation

- NotFoundError

- pulldown

- assignment1

- atmega128

- neural net

- 풀업저항

- Backpropagation

- Solution

- Floating

- leetcode

- #9

- KNN

- Features

Archives

- Today

- Total

목록backward pass (1)

코딩공부

cs231n assignment1 - two-layer neural net

cs231n assignment1 - two-layer neural net

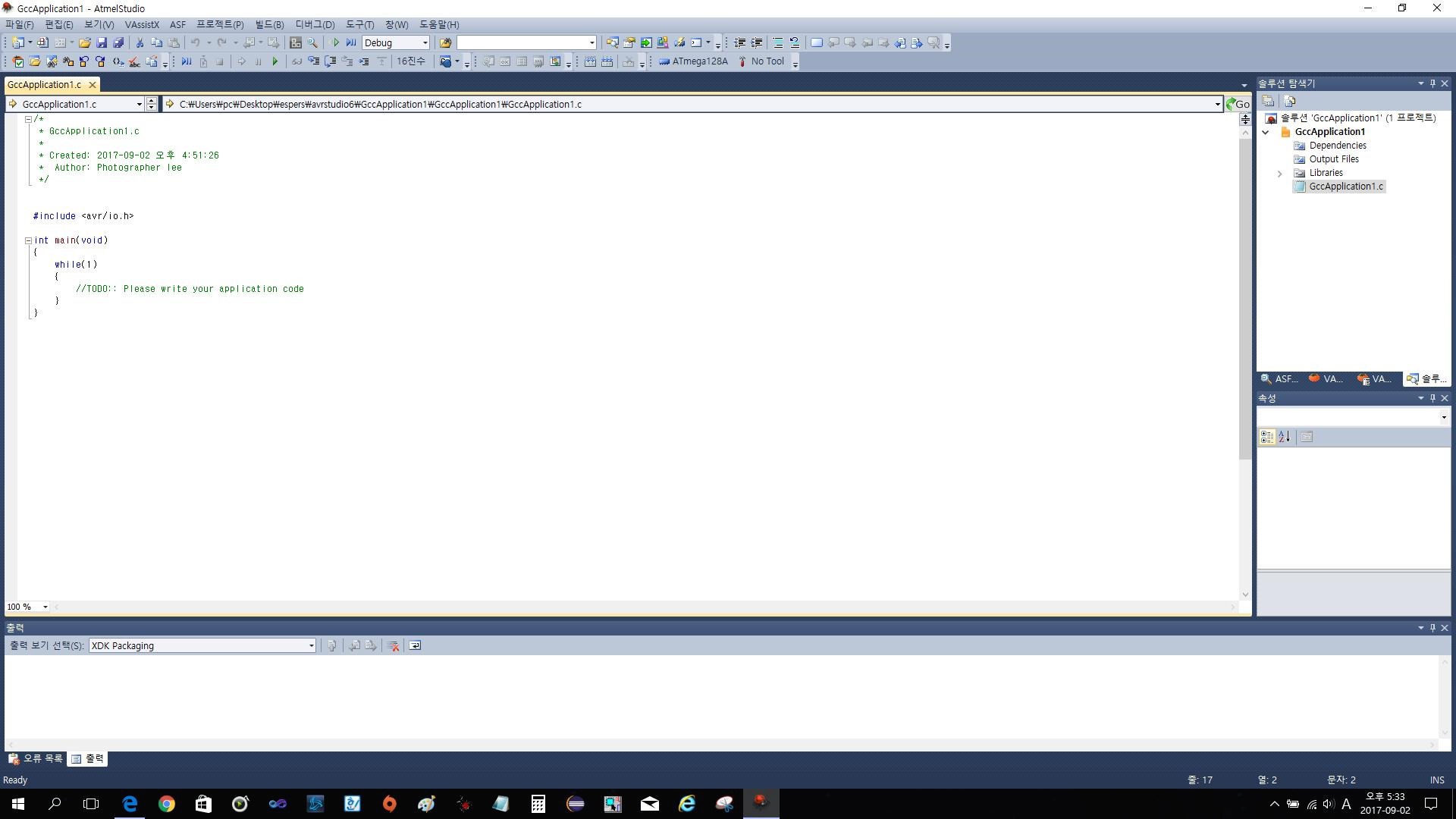

과제의 전체 코드는 https://github.com/Lee-daeho/cs231n/tree/master/assignment1에 업로드 되어 있다. 우선 softmax의 backpropagation을 설명해보고자 한다. 코드로는 다음과 같이 표현할 수 있다. 여기서 gradient를 계산하기 위해 backward pass(backpropagation)을 진행해야 하는데 이것을 자세히 풀어보았다. 이런 과정을 통해 각 input의 gradient를 구할 수 있다. 대부분의 코드는 기존의 과제 softmax나 linear classifier를 참조하면서 진행할 수 있으므로 마지막으로 Inline Question만 보겠다. 질문은 training accuracy와 testing accuracy의 차이가 크면 ..

ML , DL (2019)/cs231n

2020. 1. 10. 18:35