| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

- backward pass

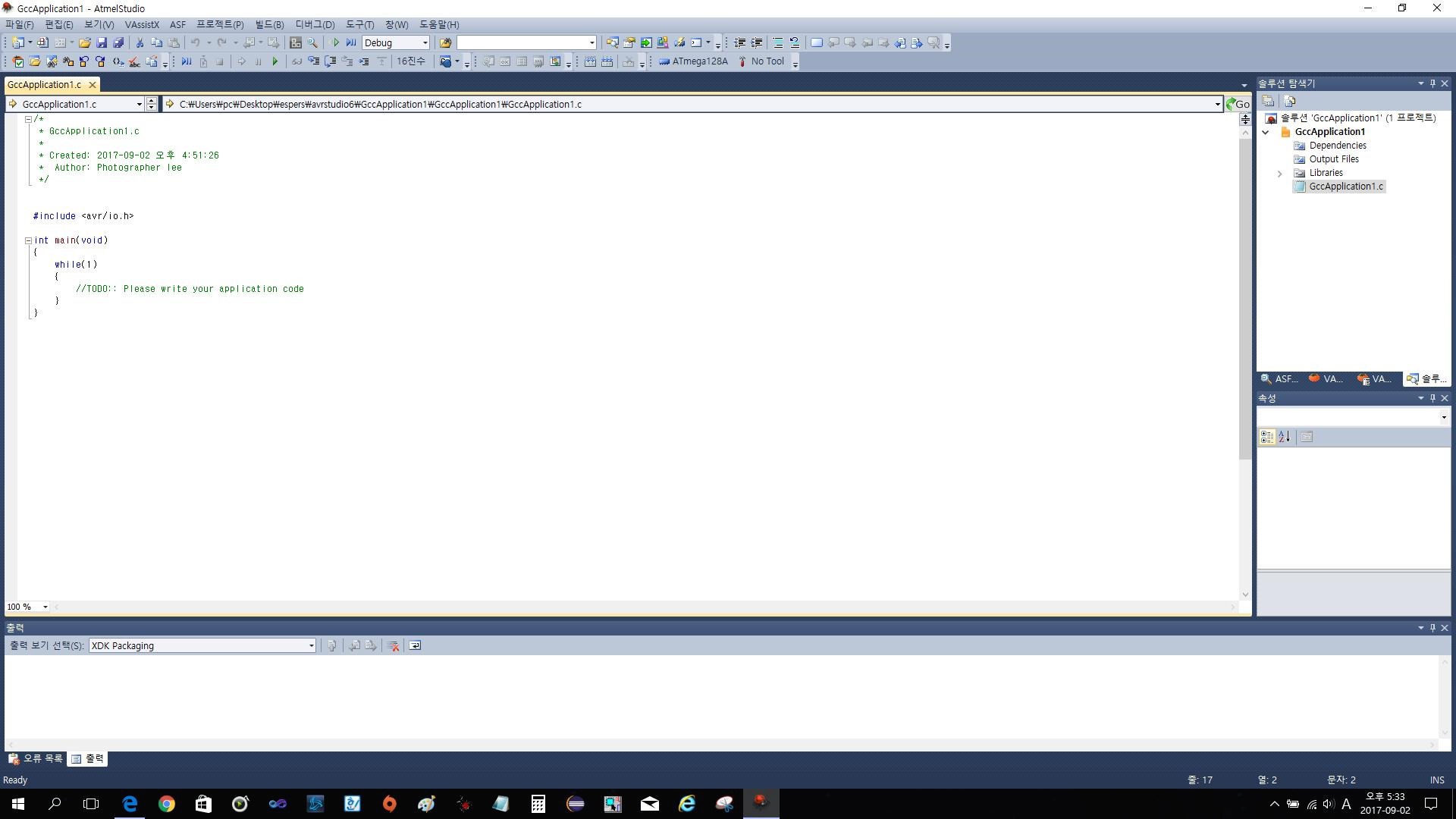

- atmega128

- Softmax

- Floating

- assignment

- Features

- Backpropagation

- Solution

- 풀업저항

- #9

- autoencoder

- softmax backpropagation

- pullup

- leetcode

- Big size image

- pyTorch

- impl

- KNN

- NotFoundError

- palindrome

- two-layer neural net

- neural net

- error

- cs231n

- TensorFlow

- 풀다운저항

- Circuit

- pulldown

- assignment1

- 회로

- Today

- Total

목록전체 글 (21)

코딩공부

https://github.com/Lee-daeho/cs231n Lee-daeho/cs231n Contribute to Lee-daeho/cs231n development by creating an account on GitHub. github.com 이번 과제는 기존의 과제들을 잘 했다면 문제없이 할 수 있는 수준의 과제였으므로 따로 설명은 하지 않는다. 이번 과제의 특징은 기존의 과제들은 이미지를 pixel단위로 구분하여 training했지만 이번에는 pixel이 아닌 extract한 feature단위로 구분하여 training하였다는 것이 특징이다. feature를 extract하는 데에는 hog(histogram of gradient)와 hsv color를 이용하였다.

cs231n assignment1 - two-layer neural net

cs231n assignment1 - two-layer neural net

과제의 전체 코드는 https://github.com/Lee-daeho/cs231n/tree/master/assignment1에 업로드 되어 있다. 우선 softmax의 backpropagation을 설명해보고자 한다. 코드로는 다음과 같이 표현할 수 있다. 여기서 gradient를 계산하기 위해 backward pass(backpropagation)을 진행해야 하는데 이것을 자세히 풀어보았다. 이런 과정을 통해 각 input의 gradient를 구할 수 있다. 대부분의 코드는 기존의 과제 softmax나 linear classifier를 참조하면서 진행할 수 있으므로 마지막으로 Inline Question만 보겠다. 질문은 training accuracy와 testing accuracy의 차이가 크면 ..

Joint Learning of Saliency Detection and Weakly Supervised Semantic Segmentation

Joint Learning of Saliency Detection and Weakly Supervised Semantic Segmentation

Yu Zeng et.al. 이번 논문은 Saliency Detection과 Weakly Supervised Semantic Segmentation을 2-stage model을 만들어 결합시킨 형태의 model에 관한 논문이다. Saliency Detection은 이미지로 부터 가장 관심이 가는 부분을 extract하는 방법이고 Weakly Supervised Semantic Segmentation(WSSS)은 이미지로부터 물체의 위치(pixel)을 extract하는데 이때 bounding box와 같은 불완전한 Label을 이용하는 방법이다. 기존에도 두가지 이론을 동시에 활용하는 방법은 존재 하였으나 본 논문의 가장 큰 차이점은 크게 두가지로 첫째는, 기존의 WSSS방법들은 pre-trained sal..

TimeTimer C# 버전

TimeTimer C# 버전

생활코딩 그룹에서 Java로 만드신걸 보고 갑자기 생각나서 만들어보았습니다. 이 사진이 최초화면입니다. 첫 이미지에도 원이라도 넣을까 하다가 그냥 깔끔하게 뺐습니다. 화면을 클릭하면 나오는 화면입니다. 시간을 설정하는 부분으로 분, 초를 정할 수 있고, 분만 또는 초만 정하고 싶다면 나머지칸을 비워두면 됩니다. 1분을 입력해 보았습니다. 입력 후 시작버튼을 누르면 타이머가 동작합니다. 최대 60분까지 설정할 수 있습니다. 시간이 지날수록 아래 사진과 같이 빨간 부분이 늘어납니다. 그리고 시간이 모두 지나면 사진처럼 Time over! 라는 메세지창이 뜨고 다시 시간을 입력하면 새로운 시간으로 타이머가 동작합니다. 사용법은 Timer.zip파일 내부의 Timer/Timer/bin/Debug/Timer.ex..

backpropagation, intuition - 2 (요약)

backpropagation, intuition - 2 (요약)

Intuitive understanding of backpropagation backpropagation의 직관적인 이해에대해 설명하는 부분이다. Chain rule은 gate가 gate의 모든 input들에 대해 구해진 gradient를 곱해야 한다고 이야기하고있고, 이러한 모든 input에 대한 곱셈이 상대적으로 쓸모없는 gate를 전체 neural network같은 복잡한 circuit의 톱니바퀴로 바꿔준다고 이 글에서 이야기하고 있다. Backpropagation은 gate들이 최종 결과값을 크게 만들기 위해 자신의 output을 얼마나 증가시키거나 줄이고싶은지에 대해 각각의 gates가 서로 대화하는것과 같다고 생각될 수 있다. -> Backpropagation의 직관적인 이해 Backpropa..