반응형

Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- palindrome

- Floating

- error

- 풀업저항

- Features

- pyTorch

- leetcode

- Softmax

- atmega128

- neural net

- assignment1

- softmax backpropagation

- impl

- two-layer neural net

- pullup

- Circuit

- pulldown

- 풀다운저항

- cs231n

- NotFoundError

- autoencoder

- Backpropagation

- KNN

- TensorFlow

- #9

- Big size image

- backward pass

- Solution

- 회로

- assignment

Archives

- Today

- Total

코딩공부

cs231n assignment1 - two-layer neural net 본문

반응형

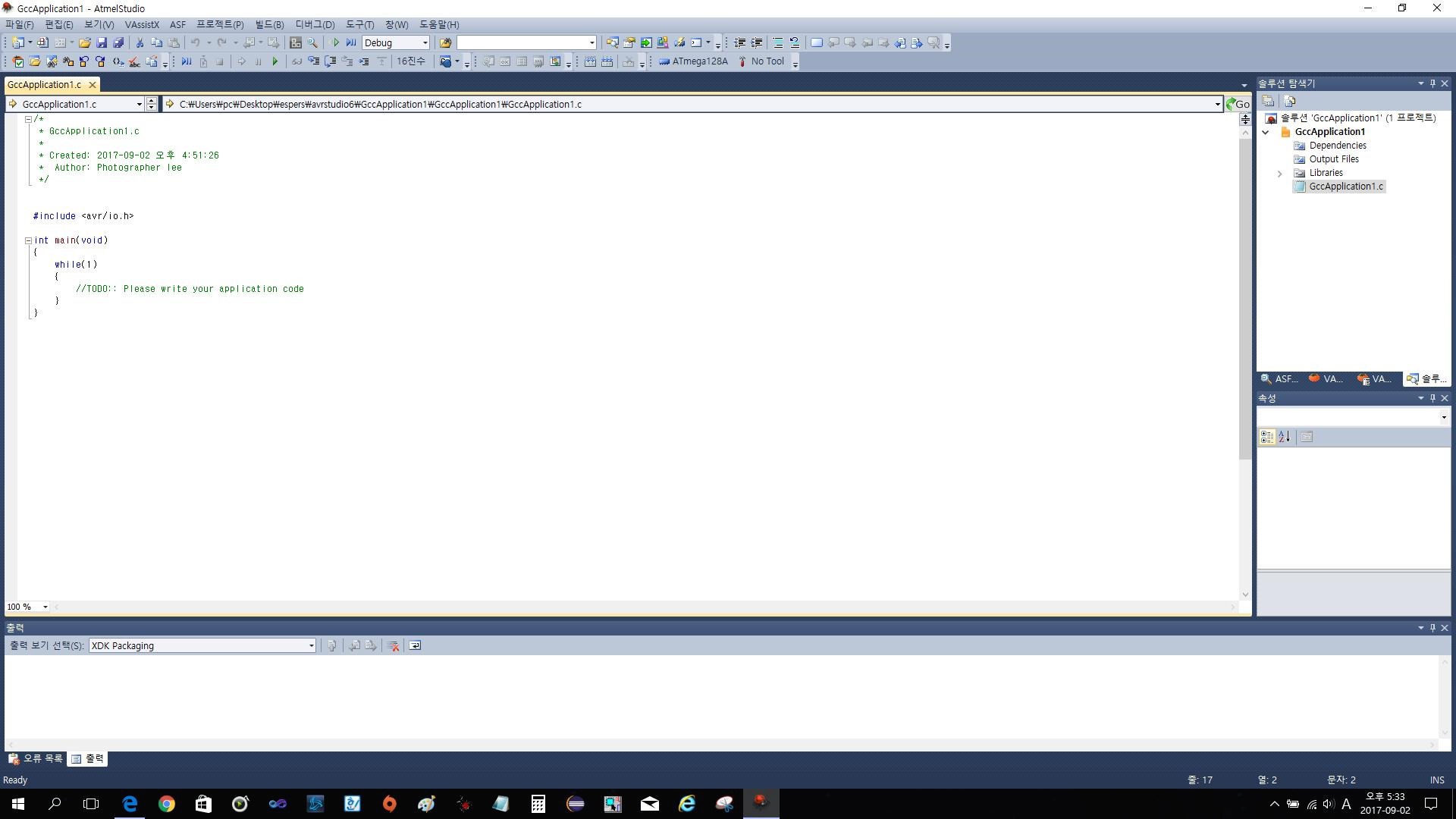

과제의 전체 코드는 https://github.com/Lee-daeho/cs231n/tree/master/assignment1에 업로드 되어 있다.

우선 softmax의 backpropagation을 설명해보고자 한다. 코드로는 다음과 같이 표현할 수 있다.

여기서 gradient를 계산하기 위해 backward pass(backpropagation)을 진행해야 하는데 이것을 자세히 풀어보았다.

이런 과정을 통해 각 input의 gradient를 구할 수 있다.

대부분의 코드는 기존의 과제 softmax나 linear classifier를 참조하면서 진행할 수 있으므로 마지막으로 Inline Question만 보겠다.

질문은 training accuracy와 testing accuracy의 차이가 크면 어떻게 차이를 줄일것인가 이다.

training accuracy와 testing accuracy의 차이가 크다는것은 model이 training set에 ovefitting하고 있다는 것이다.

overfitting을 줄이기 위해서는 dataset의 크기를 늘리거나, regularization을 진행하면 되는데, regularization이 이미 진행중이라면 regularization strength를 키우는 방법을 채택할 수 있다.

반응형

'ML , DL (2019) > cs231n' 카테고리의 다른 글

| cs231n assignment1 - features (1) | 2020.01.14 |

|---|---|

| backpropagation, intuition - 2 (요약) (0) | 2019.09.01 |

| Backpropagation, Intuitions (0) | 2019.08.22 |

| assignment1 - softmax (0) | 2019.08.20 |

| cs231n assignment1 - SVM (0) | 2019.08.17 |