| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

- Softmax

- 풀다운저항

- Circuit

- 회로

- softmax backpropagation

- error

- Backpropagation

- assignment

- NotFoundError

- leetcode

- two-layer neural net

- atmega128

- neural net

- KNN

- TensorFlow

- 풀업저항

- pyTorch

- pullup

- palindrome

- impl

- Solution

- cs231n

- assignment1

- Big size image

- Features

- autoencoder

- backward pass

- #9

- pulldown

- Floating

- Today

- Total

목록Softmax (2)

코딩공부

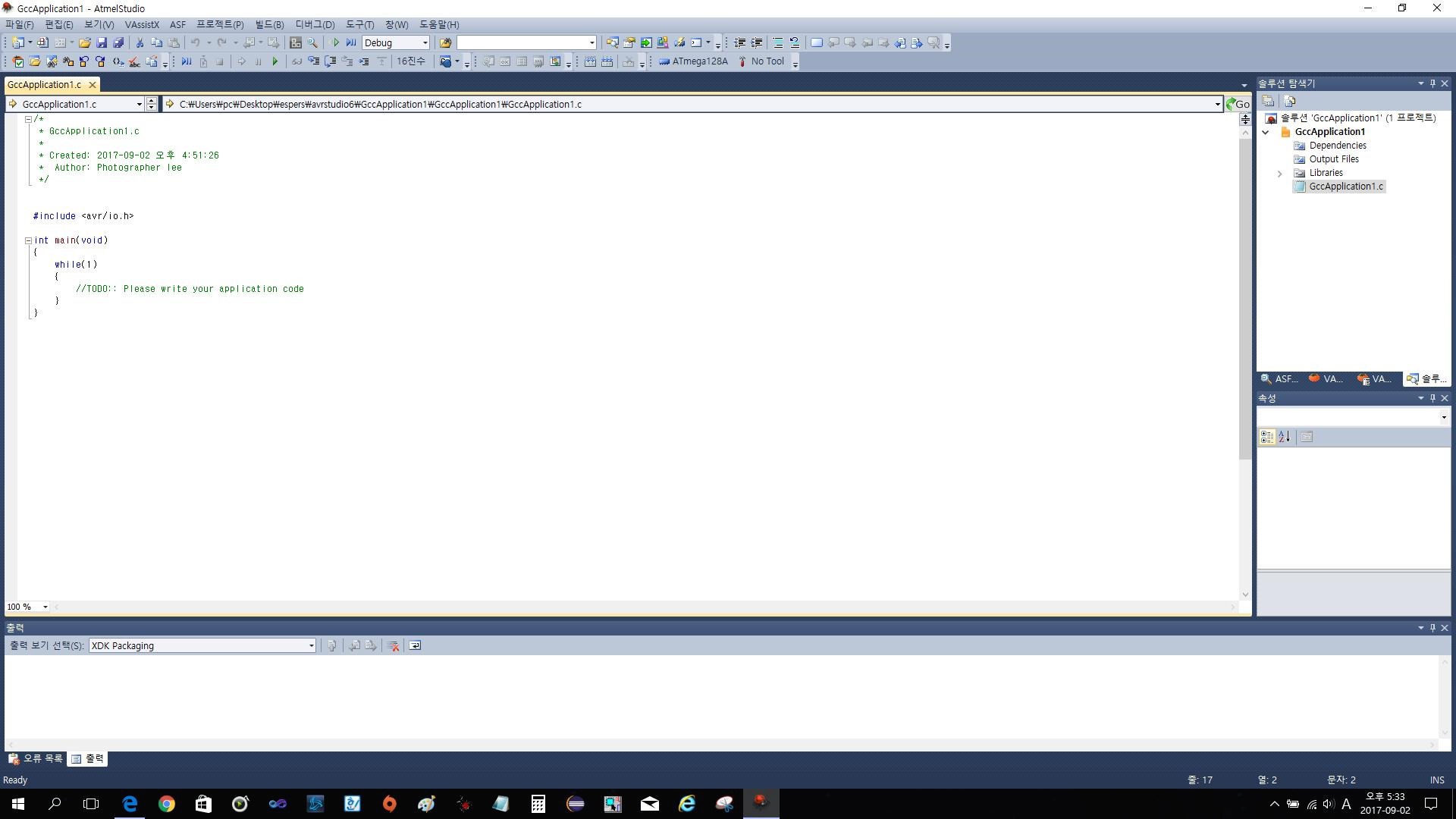

cs231n assignment1 - two-layer neural net

cs231n assignment1 - two-layer neural net

과제의 전체 코드는 https://github.com/Lee-daeho/cs231n/tree/master/assignment1에 업로드 되어 있다. 우선 softmax의 backpropagation을 설명해보고자 한다. 코드로는 다음과 같이 표현할 수 있다. 여기서 gradient를 계산하기 위해 backward pass(backpropagation)을 진행해야 하는데 이것을 자세히 풀어보았다. 이런 과정을 통해 각 input의 gradient를 구할 수 있다. 대부분의 코드는 기존의 과제 softmax나 linear classifier를 참조하면서 진행할 수 있으므로 마지막으로 Inline Question만 보겠다. 질문은 training accuracy와 testing accuracy의 차이가 크면 ..

assignment1 - softmax

assignment1 - softmax

softmax classifier는 svm과 내용이 상당히 비슷해서 SVM과 다른부분들만 설명을 하도록 하겠습니다. 설명이 없는 부분은 SVM과 같다고 생각하면 됩니다. 이번에도 코드는 github.com/Lee-daeho/cs231n 에 있습니다. 필요하신 분들은 가서 확인하시면 됩니다. scores를 구하는 부분은 SVM과 같다. 하지만 위의 TODO부분을 보면 If you are not careful here, it is easy to run into numeric instability. 라는 부분이 있다. 주의하지 않으면 numeric instability에 빠질 수 있다. 라는 의미인데 cs231n의 lecture note를 보면 다음과 같은 설명을 찾을 수 있다. Softmax function..